Seit den Anfängen der elektronischen Datenverarbeitungen (EDV) in den 1960er Jahren spielt die Speicherung und der effiziente Zugriff auf Daten eine entscheidende Rolle. Während in den Anfängen der EDV die Programmierer/-innen für die Speicherung selbst verantwortlich waren, sorgte die Entwicklung des relationalen Modells für das Datenbankmanagement durch Edgar F. Codd in den 1970er Jahren für eine Revolution in der Datenhaltung: Datenbanksysteme schafften einen einheitlichen und standardisierten Zugriff auf gespeicherte Daten, sodass verschiedene Anwendungen auf den selben Datenbestand arbeiten können und die Softwareentwicklerinnen und Softwareentwickler sich um die Details der effizienten Datenspeicherung nicht selber kümmern müssen. Bis heute sind Datenbanksysteme nicht mehr wegzudenken und finden sich auf nahezu allen Computersystemen – vom Smartphone bis zum Servercluster – wieder.

In den letzten Jahren hat neben der Speicherung von Daten eine neue Art der Datenverarbeitung an Bedeutung gewonnen: Die unmittelbare Verarbeitung von Daten in Echtzeit, ohne dass diese zuvor abgespeichert werden müssen. Bei der Verarbeitung dieser Art von Daten stehen wir im Moment da, wo wir in den 1960er Jahren mit der Speicherung von Daten standen: Jede/r entwickelt eigene Lösungen und erfinden das Rad immer wieder neu. 2007 haben wir in der Arbeitsgruppe „Informationssysteme“ der Universität Oldenburg angefangen darüber nachzudenken, wie wir all das, was man von Datenbanksystemen kennt, auf Daten anwenden kann, die in einem kontinuierlichen Strom vorliegen. Wie kann ein potenziell unendlicher Storm an Sensor-, Finanztransaktions-, oder Logdaten auf ähnlicher weise standardisiert verarbeitet werden, wie wir es von Datenbanksystemen kennen. In dem Zuge ist im Forschungsprojekt „Odysseus“ eine innovative Technologie entstanden, die die Umsetzung von Softwarelösungen für das Streaming Analytics einfacher und flexibler macht. In ihr sind über 150 Abschlussarbeiten (Diplom, Bachelor, Master) und mehr als 10 Dissertationen eingeflossen. In über 10 Forschungsprojekten war diese Technologie schon im Einsatz. Sie ist die Basis des Conlytics Data Stream Managers.

10+

Jahre F & E

150+

Abschlussarbeiten

10+

Dissertationen

10+

Forschungsprojekte

Digitale Technologien wie vernetzte Maschinen der Industrie 4.0, moderne Windkraftanlagen und Vorhersagesysteme, beispielsweise für den Straßenverkehr, erfassen permanent Informationen wie Sensorwerte, die Stärke des Winds oder das Verkehrsaufkommen an einer Kreuzung. Solche Daten können eine wichtige Grundlage für Entscheidungen darstellen – vorausgesetzt, Sie machen sich die Daten in Form von Auswertungen zugänglich. Die Sensordatenverarbeitung senkt Kosten, ermöglicht neue, innovative Produkte und führt zu höheren Umsätzen.

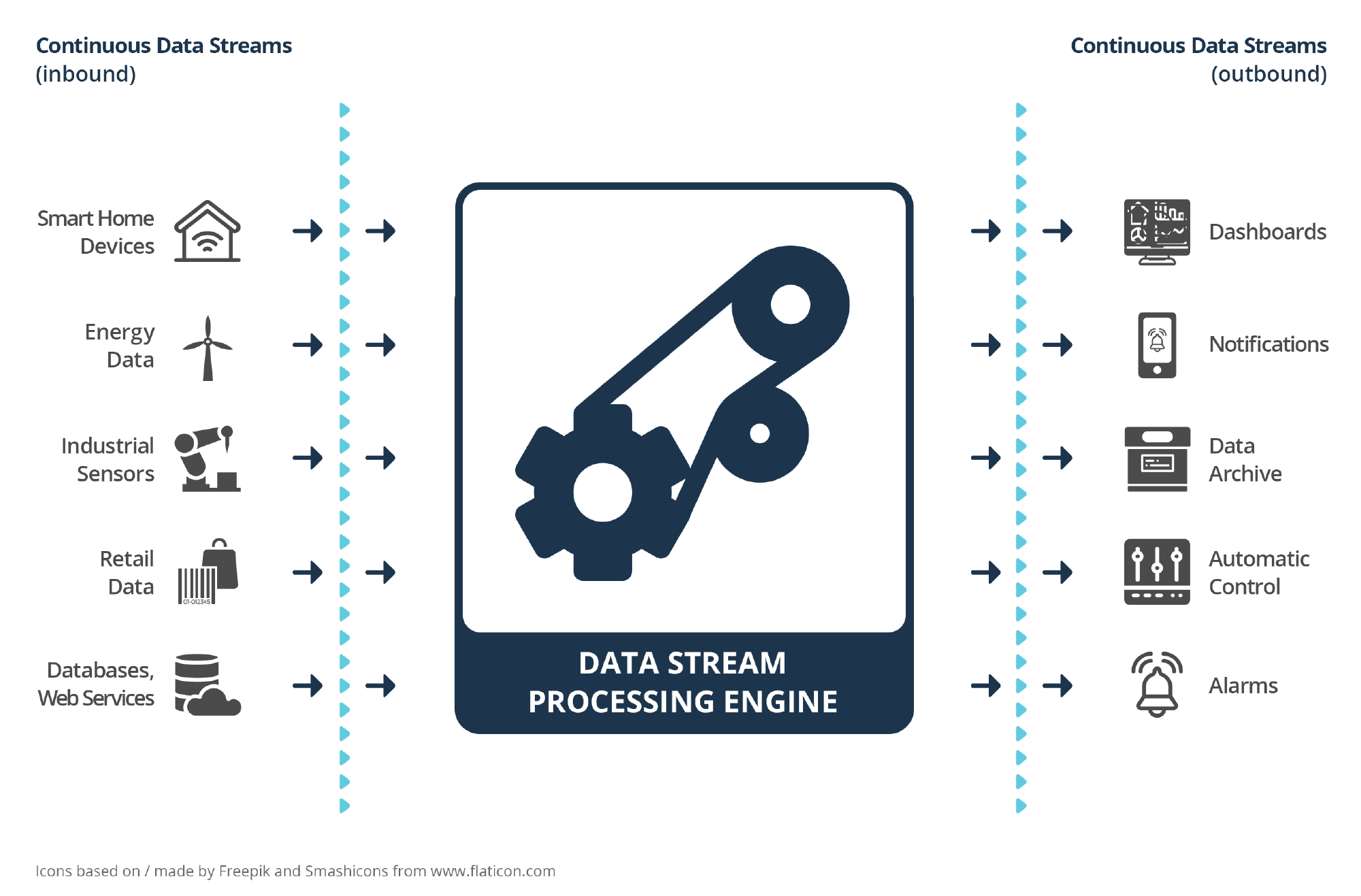

Die Datenstromanalyse mit unseren Softwarelösungen wertet die Daten in dem Moment aus, in dem sie entstehen, und stellt dem Anwender und Entscheider die Informationen zur Verfügung. Diese können etwa auf Computern visualisiert, im Archiv gespeichert oder automatisiert eine weitere Handlung einleiten, etwa einen Alarm auslösen. Wie Sie den Conlytics Data Stream Manager einsetzen, welche Daten Sie erfassen und verarbeiten und welche Handlungen automatisiert durch die Auswertungen eingeleitet werden, können Sie selbst entscheiden. Das Produkt passt sich Ihren Anforderungen an.

Die Flexibilität wird dadurch ermöglicht, dass die Lösung individuell aus verschiedenen Operatoren zusammengesetzt wird, die je nach Bedarf beliebig häufig verwendet werden können. Operatoren, die zur Verfügung stehen, sind unter anderem:

- Datenzugriffsoperatoren: Anbindung beliebiger Datenquellen in unterschiedlichen Formaten.

- Filteroperatoren: Relevante Daten werden aus der Masse herausgefiltert.

- Transformationsoperatoren: Kennzahlen werden umgerechnet, beispielsweise von Zoll in Zentimeter.

- Joinoperatoren: Elemente aus verschiedenen Datenströmen, etwa von zwei verschiedenen Sensoren, werden so zusammengefügt, dass sie anschließend dennoch zuzuordnen sind.

- Aggregationsoperatoren: Berechnungen von Summen, Durchschnittswerten und vielen weiteren Aggregationen.

- Fensteroperatoren: Das Verarbeiten von Werten in einem bestimmten Fenster, beispielsweise innerhalb der letzten Stunde oder die letzten zehn verfügbaren Werte.

- Selbstlernende Operatoren: Intelligente Operatoren lernen eigenständig dazu und erkennen somit beispielsweise Anomalien in Ihren Daten (Künstliche Intelligenz).

- und viele weitere …

100+

sofort nutzbare Operatoren